Dieses mal gibt es etwas aus dem Bereich (Achtung Buzzword Bingo Bullshit!!!) „high“ Performance Networking.

Ich hatte im Rahmen einer Teststellung die Gelegenheit zwei Mellanox ConnectX-4LX 40GbE (CX4131A bzw. MCX4131A-BCAT) mit einem 3m QSFP+ (MC2210128-003) testen zu können.

Sofort Karten auspacken, in meine Testmaschine werfen und nix geht. ESXi 5.5 zeigt mir zwar die Karte an, aber nicht als Netzwerkkarte. Zweites Image mit ESXi 6.0 gestarten und… das gleiche Bild.

Ok dann halt im Passthrough Modus. Dabei zeigen sich folgende Verhaltensweisen:

Windows Server 2008 R2

Ähm… nöööö, da ging garnichts, zumindestens nicht automatisch. Nachdem ich den Treiber gefunden hatte, ging es gut. Doch wozu brauch ich 40G unter Windows in einer VM? ATTO Benchmarks auf SAN abfeuern, welches bereits wegen des Dell H310/M1015 bereits bei 600MBit/s aufgibt. Nee danke.

VMWare ESXi

Da ich kein VCenter habe und keine Lust darauf habe ein custom Image nur für diesen Test zu bauen, kann ich außer der Einleitung nichts dazu sagen.

*Ubuntu 16.04.2/Debian 8

gestartet, erkannt und funktionierte

Daher habe ich auch die weiteren Tests mit 16.04.2 gemacht.

Treiber

Lagen nicht bei, hab ich nach etwas suchen dann doch direkt beim Hersteller gefunden:

Link zum Mellanox Treiber

Benchmarks

Die waren mit einigen Hindernissen verbunden. Zuerst hatte ich als B-Ende einen Core2Quad Q8200 genutzt.

Der kam mit etwas Optimierung nur auf 17,9 GBit/s, zudem waren alle vier Kerne auf anschlag 100%.

![]()

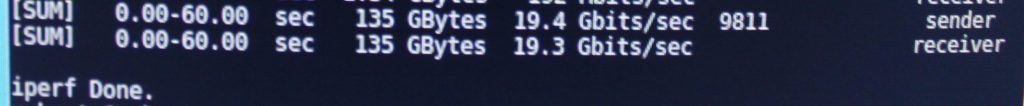

Als nächstes habe ich dann den i3-2100 zum Testen herangezogen, welcher auch direkt ein besseres Bild zeigte (19,4GBit/s):

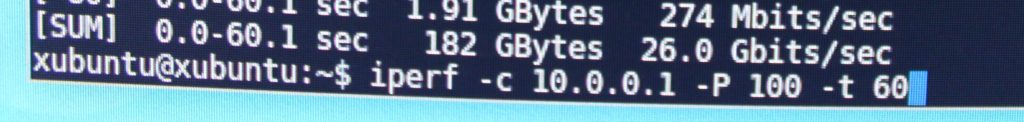

Diesmal war es aber iperf3, welches sich als Flaschenhals zeigte. iperf brachte da ein doch besseres Ergebnis (25,5-26,0GBit/s):

Ich merke jedoch, dass solche Hardware eindeutig für PCI Express 3.0 ausgelegt ist und ich einfach an die Limits von PCIe 2.0/2.1 stoße. Bei 10GBE ist das nämlich kein Problem.

Fazit

Mit einem „Marktpreis“ von ca. 500€ – nur Karte – ohne Kabel oder QSFP+ Modul – könnte 40GBE jetzt auch bei einem breiteren Publikum ankommen. Mir zeigte es vor allem, dass nach Dualport 10GBE nur 40GBE bzw. dual 40GBE kommen kann, PCIe 3.0 oder besser vorrausgesetzt.

Im Zusammenhang mit einem Mellanox 40GBE 12 Port Switch (MSX1012B-2BFS) geht da bereits einiges, vor allem wenn man nur noch zwei Ports braucht, um einen Nutanix/Supermicro Server mit vier Nodes á zweimal 10GBE SFP+ mit einem Kabel anzuschließen. Zudem können zwei dieser Switches auf einer Höheneinheit montiert werden.

Bei sowas kann ich mir gut vorstellen diese beiden untereinander zu verbinden und mit dem Management Switch anzubinden, dass ganze dann per 40GBE Redundant auf LWL (SMF) in Richtung Core Switch zu schicken. (Außer man macht es so wie ich aktuell und geht mit zwei QSFP+ auf SFP+ auf RJ-45 um den Management Switch anzubinden 😛 )

Schöne neue Welt 😀

Archiv der Kategorie: Netzwerk

Demo: Lautstärke HP Procurve 5308xl

ASG Uplinkausgleich & Multipathregeln

Damals als ich die Sophos SG430 eingerichtet hatte war eigentlich noch alles gut, bis ich auf die Idee gekommen bin mehrere Internetanschlüsse, damals 10MBit/s SDSL, 2MBIt/s SDSL, 6MBit/s ADSL (Annex B – Business) & 16MBit/s ADSL (Annex J), zu koppeln. Also alles über je eine Schnittstelle zur ASG geführt und die beiden SDSL und die langsame ADSL Leitung per Uplinkausgleich gekoppelt, welches zur Folge hatte, dass sich verschiedene Lastquellen, wie PACS (Radiologiebilderspeicher) und das Laborsystem, auf verschiedene Leitungen verteilt wurde. Jedoch war die Auswahl die von der Firewall getroffen wurde eher zufällig, wodurch die großen PACS Datenmengen (so ca. 18GB) über die 2er SDSL und die Labordaten (ca. 800MB) über die 10er SDSL geschubst wurden. Dieses Verhalten gefiel mir jedoch nicht so recht, weswegen ich zusätzlich zum Uplinkausgleich noch die Multipathregeln aktivierte. Diese ermöglichten mir gewisse Quellen und Dienste an gewisse Ziel-/Leitungsgruppen zu binden, welches auch bei direktem Test auch als funktional herausstellte. Jedoch zeigte sich am selbigen Abend ein anderes Bild, denn auf einmal ging der PACS Traffic über die 600kbit/s Leitung per ADSL raus, der Labortraffic über die 2er SDSL, der Traffic zum Informationsportal über die andere ADSL (was nicht besonders war, da diese eine dynamische IP hatte und man auf IP Basis freigeschaltet wurde) und der Katzenvideotraffic* wurde über die 10er SDSL rausgeblasen. Als Ursache konnte ich den Uplinkausgleich festmachen, der auf vermutlich Layer 2 angriff und die Multipathregeln die auf Layer 3-7 ihr Unwesen trieben.

Die Lösung die ich ausarbeiten konnte, war durch das deaktivieren des Uplinkausgleich zu erreichen. Damit benötigte ich zwar mehr Multipathregeln, jedoch funktionierten diese dann wie erhofft.

*(bzw. sonstiger „Multimediatraffic“ der „Unterhaltungszwecken“ dient)

Review: Asus P9D WS / Das Testsystem für ca.1000€

Anforderung

Es sollte eine Intelplattform Quadcore mit 32GB RAM ECC, PCIe Splitter, Workstation/Server Hardware, Hardwarebeschleunigung für VT-x & VT-d

Zielsetzung

Virtualisierungsplattform mit guter * PCIe Anbindung und Hardwarepassthrough

* PCIe x16 von der CPU soll gesplittet werden und nicht nur vom Chipsatz kommen

Teileliste

Asus P9D WS – ca. 220€

– Workstation Mainboard

– ECC Support

– Intel C226 Chipsatz

– Splittet den PCIe 3.0 x16 von der CPU nach Bedarf auf x16 oder x8/x8 oder x8/x4/x4

– Chipsatz liefert 6xSATA3/PCIe 2.0 x4/PCIe 2.0 x1/2x PCI/2x Intel I210 LAN onBoard

Kingston KVR16E11K4/32 32GB DDR3 ECC 1600MHz CL11 – ca. 235€

– 32GB ECC RAM der auf der HCL von Kingston steht

Intel Xeon E3-1231v3 4×3,4GHz – ca. 280€

– lieber nicht, besser E3-1245v3, weil dieser eine onBoard GPU hat

IBM M1015 – 120€

– IT-Mode für ZFS

Nvidia FX 5800 PCI – 20€

– weil CPU ohne onBoard GPU

bequiet! Pore Power L7-530W – ca. 60€

Fractal Design ARC MIDI R2 – 80€

Anwendungsfall

Bei mir läuft ESXi 5.5 drauf, dabei wird der IBM M1015 direkt an die FreeNAS VM durchgereicht und bekommt so die Festplatten mit 12GB RAM. Speedlimit liegt bei ca. 600MB/s, eben der Flaschenhals des Controllers mit SAS2/SATA3. Diese stellt einen FTP Server und ein iSCSI Target bereit. Dieses wird auf der ESXi als entsprechendes Blockdevice eingebunden.

Darauf kommt eine Windows VM die Grafikkarte (ATI HD 5770) durchgereicht und der Store liegt auf dem iSCSI Target.

Dazu kommt noch eine der Intel X520 10GBE für den guten Datendurchsatz, die auch iSCSI an einen weiteren Host weiterreichen kann.

Außerdem eine ATI HD 5770, die bald mal gegen was neueres gewechselt werden muss, zudem verdeckt zwar einen PCI Slot, aber egal.

Was kommen könnte

Neuere Grafikkarte, da die ATI HD 5770 etwas in die Jahre gekommen ist. Wichtig ist nur, dass die nur genau zwei Slots belegen darf, da sonst kein Platz mehr für die 10GBE Karte ist.

NVMe Flash Cache/Storage über den Chipsatz. Dazu noch ein neuer Storagecontroler, z.B. Broadcom 9300-8i um mehr Bandbreite zu dem Festplatten zu haben. Für einen 9300-16i müsste ein neues Case her oder ein 4i um mit vier SATA SSDs zu arbeiten.

Mehr USB/LAN kann übrigens auch nicht schaden.

Benchmark Ergebnisse

| Typ | Model | CPU cb | CPU cb Single | MP Ratio | Grafikkarte | OpenGL FPS |

| Intel NUC5i5RYH | Intel i5-5250U 2x@1,6GHz | 259 | 108 | 2,39 | Intel HD 6000 | 36,74 |

| Intel i3-2100 2x@3,1GHz | 267 | 105 | 2,55 | ATI HD 6670 | 37,76 | |

| Lenovo W520 | Intel i7-2720QM 4x@2,2GHz | 427 | 102 | 4,21 | Nvidia Quadro 1000M | 28,91 |

| Lenovo T440p | Intel i7-4710MQ 4x@2,5GHz | 522 | 137 | 3,79 | Nvidia GeForce GT 730M | 52,34 |

| dieses System | Intel E3-1231 v3 4x@3,4GHz | 727 | 151 | 4,83 | ATI HD 5770 | 77,81 |

| HP Workstation | Intel i7-4770 4x@3,4GHz | 729 | 148 | 4,94 | Nvidia Quadro K600 | 33,02 |

Fazit

Als VM Host für zuhause ist dieses System sehr gut geeignet, jedoch merke ich, dass mir die Anzahl der von der CPU kommenden PCIe Lanes nicht ausreichen wird. Daher denke ich aktuell über eine CPU mit 40 Lanes auf Basis des Sockel 2011-3 nach. Dabei sind zwar die Mainboards größer, jedoch wird mein Bedarf gewiss weiter steigen.

endlich 10GBE? ja!

Da bin ich mal wieder auf ebay unterwegs und suche nach“X520-DA1/DA2“, …ups

300€ & 2 Tage später liegt ein Set aus zwei Intel X520-DA1 mit 3m SFP+ Kabel und zwei Intel 10GBE SFPs Multimode (FTLX8571D3BCV-IT) im Briefkasten. Wenn ich die Dinger schon mal habe, kann ich auch damit spielen gehen.

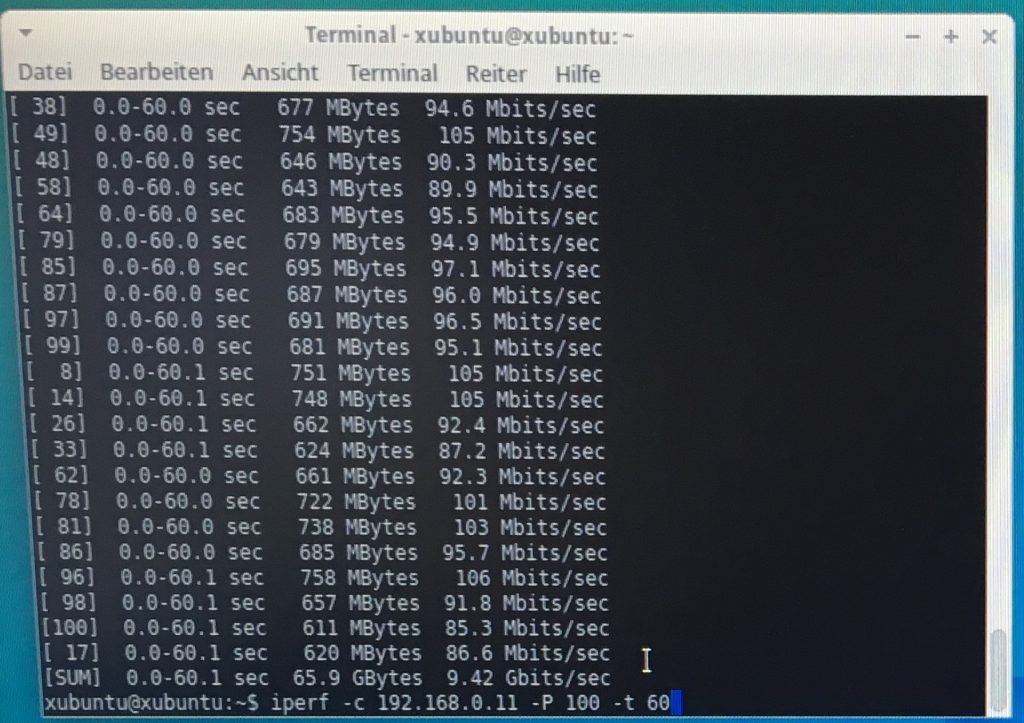

Also eingebaut, Linux gestartet, iperf rausgeholt und losgetestet.

Ergebnis 9,42GBit/s…ok, damit kann ich arbeiten 😀