Ich hatte am Wochenende mal wieder lust an etwas herumzuschrauben, dabei ist mir mein AVM 300E aufgefallen, dass der nur ein bzw. zwei Balken Signalstärke anzeigt. Also aufgeschraubt und nachgesehen, was da noch so geht uns siehe da, zwei IPX Pigtail Anschlüsse. Da ich von meinem TL-WR1043ND, bei dem ich dem ich drei TL-ANT2408CL angeschraubt habe, noch die drei Serienantennen übrig hatte habe ich mal nach „IPX Pigtail Adapter auf RP-SMA“ gesucht. Im Prinzip muss man mit einer Zange nur zwei Schlitze in das Gehäuse klipsen und schon kann man die RP-SMA Anschlüsse befestigen. Dannach nur noch die Antennen dranschrauben und schon geht es besser, alternativ auch gern eine TL-ANT2424B als Uplink.

Mit den „neuen“ Antennen komme ich nun auf mindestens drei Balken.

Archiv für den Monat: März 2017

nach 10GBE geht doch noch was… ODER???

Dieses mal gibt es etwas aus dem Bereich (Achtung Buzzword Bingo Bullshit!!!) „high“ Performance Networking.

Ich hatte im Rahmen einer Teststellung die Gelegenheit zwei Mellanox ConnectX-4LX 40GbE (CX4131A bzw. MCX4131A-BCAT) mit einem 3m QSFP+ (MC2210128-003) testen zu können.

Sofort Karten auspacken, in meine Testmaschine werfen und nix geht. ESXi 5.5 zeigt mir zwar die Karte an, aber nicht als Netzwerkkarte. Zweites Image mit ESXi 6.0 gestarten und… das gleiche Bild.

Ok dann halt im Passthrough Modus. Dabei zeigen sich folgende Verhaltensweisen:

Windows Server 2008 R2

Ähm… nöööö, da ging garnichts, zumindestens nicht automatisch. Nachdem ich den Treiber gefunden hatte, ging es gut. Doch wozu brauch ich 40G unter Windows in einer VM? ATTO Benchmarks auf SAN abfeuern, welches bereits wegen des Dell H310/M1015 bereits bei 600MBit/s aufgibt. Nee danke.

VMWare ESXi

Da ich kein VCenter habe und keine Lust darauf habe ein custom Image nur für diesen Test zu bauen, kann ich außer der Einleitung nichts dazu sagen.

*Ubuntu 16.04.2/Debian 8

gestartet, erkannt und funktionierte

Daher habe ich auch die weiteren Tests mit 16.04.2 gemacht.

Treiber

Lagen nicht bei, hab ich nach etwas suchen dann doch direkt beim Hersteller gefunden:

Link zum Mellanox Treiber

Benchmarks

Die waren mit einigen Hindernissen verbunden. Zuerst hatte ich als B-Ende einen Core2Quad Q8200 genutzt.

Der kam mit etwas Optimierung nur auf 17,9 GBit/s, zudem waren alle vier Kerne auf anschlag 100%.

![]()

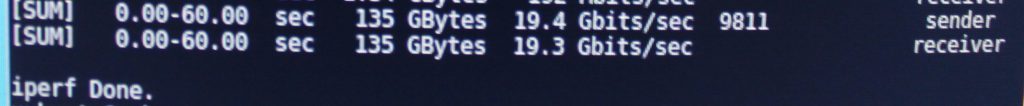

Als nächstes habe ich dann den i3-2100 zum Testen herangezogen, welcher auch direkt ein besseres Bild zeigte (19,4GBit/s):

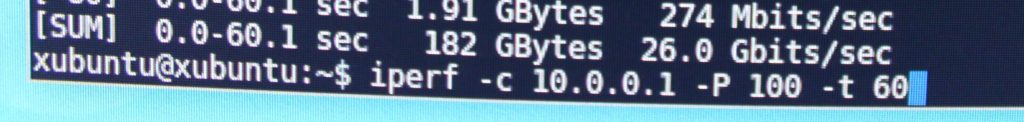

Diesmal war es aber iperf3, welches sich als Flaschenhals zeigte. iperf brachte da ein doch besseres Ergebnis (25,5-26,0GBit/s):

Ich merke jedoch, dass solche Hardware eindeutig für PCI Express 3.0 ausgelegt ist und ich einfach an die Limits von PCIe 2.0/2.1 stoße. Bei 10GBE ist das nämlich kein Problem.

Fazit

Mit einem „Marktpreis“ von ca. 500€ – nur Karte – ohne Kabel oder QSFP+ Modul – könnte 40GBE jetzt auch bei einem breiteren Publikum ankommen. Mir zeigte es vor allem, dass nach Dualport 10GBE nur 40GBE bzw. dual 40GBE kommen kann, PCIe 3.0 oder besser vorrausgesetzt.

Im Zusammenhang mit einem Mellanox 40GBE 12 Port Switch (MSX1012B-2BFS) geht da bereits einiges, vor allem wenn man nur noch zwei Ports braucht, um einen Nutanix/Supermicro Server mit vier Nodes á zweimal 10GBE SFP+ mit einem Kabel anzuschließen. Zudem können zwei dieser Switches auf einer Höheneinheit montiert werden.

Bei sowas kann ich mir gut vorstellen diese beiden untereinander zu verbinden und mit dem Management Switch anzubinden, dass ganze dann per 40GBE Redundant auf LWL (SMF) in Richtung Core Switch zu schicken. (Außer man macht es so wie ich aktuell und geht mit zwei QSFP+ auf SFP+ auf RJ-45 um den Management Switch anzubinden 😛 )

Schöne neue Welt 😀