This is an comment so Morten Video „My Cool Data Center, is getting Hot, Need to Improve on That – 527“.

Hi Morten,

I’ve ask my colleagues from the datacenter expert team how they would cool such a small 8-20m² colocation room.

They see the following as essential:

do:

– filter the air (like an K&N filter from the car tuning store)

– mesure or calculate the air flow of your servers

– use a return flap on the intake and outtake, to have a defined airflow

– monitor temperature and humidity

– use A & B feed with ups and genset (they build Tier II to IV Datacenters the hole day)

– use surveillance, access control, intrusion detection (and allso high secure ones)

– use redundancy all time n+1/2 (WTF – for at home?!?)

don’t do:

– use high pressure intake fans, otherwise the fans in the server will become generators and that would damage the Servers over time

so one fan that push out the hot air is just fine

– short circuit the air typ’s

Solution:

They told me tho use an PLC to controle the system like a Siemens Logo.

My idea was to use an raspi or aduino with

2/3x DHT22 (behind the rack, in front of/in the room, outside)

5V Relay board 4 or 8 channels to turn the fan’s on and off to reduce power consumption (easy way) or if possible control fan speeds

some scripts, wiringPi, lol_dht22

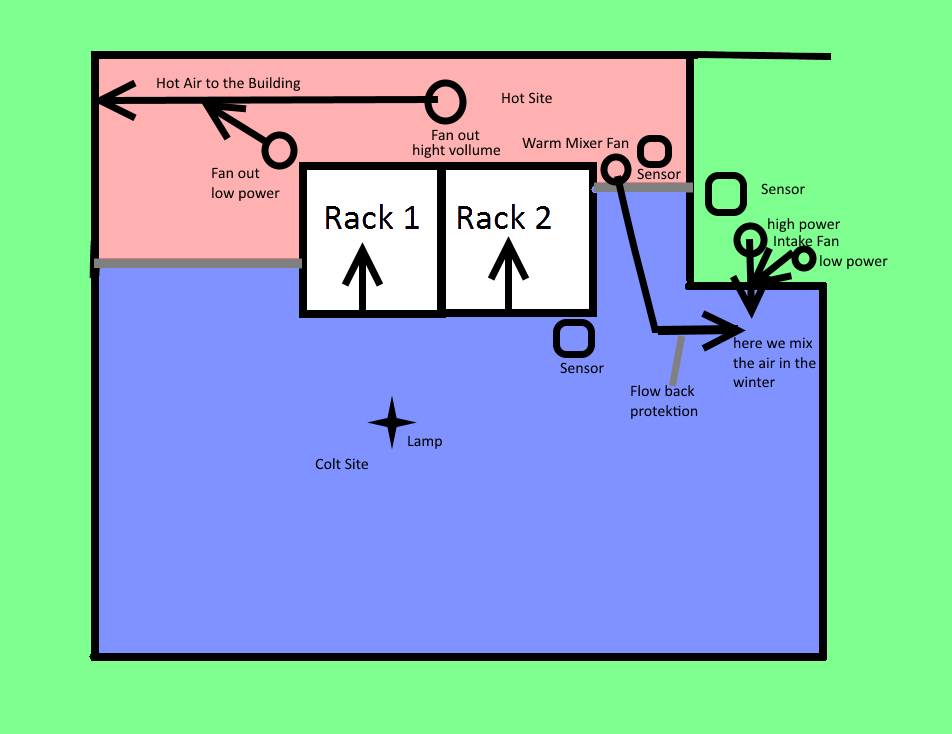

Here is an shot overview of my plan:

And here the simple script to check temperature and humidity, to make a switching decision:

#!/bin/bash

#

# Script mit schaltbefehlen je nach Luftfeuchtigkeit und Temperatur

# Script to controll air exchange

# Variablen

#humi=$(sudo /var/www/loldht 7 | grep -i "humidity" | cut -d ' ' -f3)

humi=$(sudo /var/www/loldht 7 | grep -i "humidity" | cut -d ' ' -f3 | cut -d '.' -f1)

#temp=$(sudo /var/www/loldht 7 | grep -i "temperature" | cut -d ' ' -f7)

temp=$(sudo /var/www/loldht 7 | grep -i "temperature" | cut -d ' ' -f7 | cut -d '.' -f1)

# hier Vergleichswert einlesen

# fill variables with data

humi_max=70

temp_max=35

temp_mode25=25

temp_mode24=24

temp_mode23=23

# Luftfeuchtigkeit - humidity 70% Max.

if [ $humi -ge $humi_max ];

then

/home/pi/schalter/r1-on.sh

/home/pi/schalter/r2-on.sh

sleep 600

/home/pi/schalter/r1-off.sh

/home/pi/schalter/r2-off.sh

else

# Temperatur 35° Max.

if [ $temp -ge $temp_max ];

then

/home/pi/schalter/r1-on.sh

/home/pi/schalter/r2-on.sh

sleep 10

/home/pi/schalter/r1-off.sh

/home/pi/schalter/r2-off.sh

else

# Temperatur 25° Max.

if [ $temp -ge $temp_mode25 ];

then

/home/pi/schalter/r1-on.sh

/home/pi/schalter/r2-on.sh

sleep 5

/home/pi/schalter/r1-off.sh

/home/pi/schalter/r2-off.sh

else

# Temperatur 24° Max.

if [ $temp -ge $temp_mode24 ];

then

/home/pi/schalter/r1-on.sh

/home/pi/schalter/r2-on.sh

sleep 4

/home/pi/schalter/r1-off.sh

/home/pi/schalter/r2-off.sh

else

# Temperatur 23° Max.

if [ $temp -ge $temp_mode23 ];

then

/home/pi/schalter/r1-on.sh

/home/pi/schalter/r2-on.sh

sleep 3

/home/pi/schalter/r1-off.sh

/home/pi/schalter/r2-off.sh

else

echo "nö"

#Ende der IF's

fi

fi

fi

fi

fi

#

# Test

echo "Luftfeuchtigkeit " $humi # > /home/pi/temp/demo

echo "Temperatur " $temp # >> /home/pi/temp/demo

or the download with all my tapstops: